模子学问蒸馏新SOTA!告据说统散度蒸馏|腾讯优图&中科大出品

用大模子“蒸馏”小模子,有新招了!

致使能在不同类型和架构的LLMs(大言语模子)上达到新SOTA。

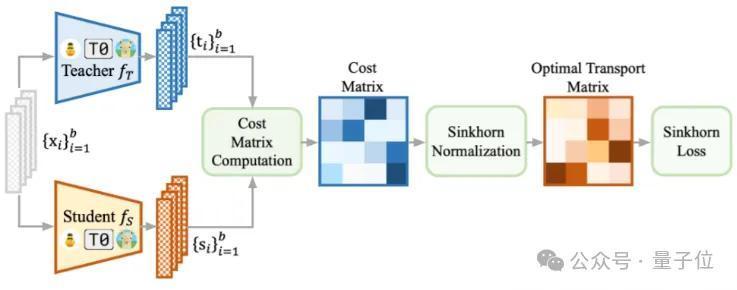

这即是来自中科大、腾讯优图实验室建议的一种基于Sinkhorn距离的学问蒸馏方式,能把大的、复杂的素养模子的学问“蒸馏”到小的、浅陋的学生模子中,从而让小模子也能像大模子一样作事。

之是以建议新方式,主若是现存的学问蒸馏(KD)方式都有各自的局限性:

当两个模子的输出各异较大时,它们就不太管用了。

KL散度:会导致学生模子的输出变得过于平滑,失去了分辩性;RKL散度:会让学生的输出变得太浅陋,弗成很好地师法素养模子;JS散度:会让学生模子低估宝贵事件的概率;而基于Sinkhorn距离的新方式能更准确地揣摸和松开素养模子和学生模子之间的各异,从而栽培了学生模子的性能。

此外,商议还建议了一种基于批量的重构方式,从而在高维空间中捕捉跨样本散播的几何复杂性。

最终,通过在两个流行的当然言语处理测试集(GLUE和SuperGLUE)上测试,新方式在编码器、编码器-解码器以及解码器等不同架构的统共类型LLMs上均优于现时的开头进方式。

商议布景

学问蒸馏的建议是为了通过对都素养模子的软主义(举例输出logits和中间层暗示)来将素养模子内在固有的学问传递给学生模子。

给定测验斡旋的一个样本x_i过甚信得过标签 ∈ ℝ,来自素养模子和学生模子的输出logits ∈ ℝ和 ∈ ℝ不错由以下式子得到:

其中为softmax函数, τ是温度参数, d是输出logits的维度。基于logit的学问蒸馏的主义是σΤ最小化测量散度J(,)以达成学问传递。

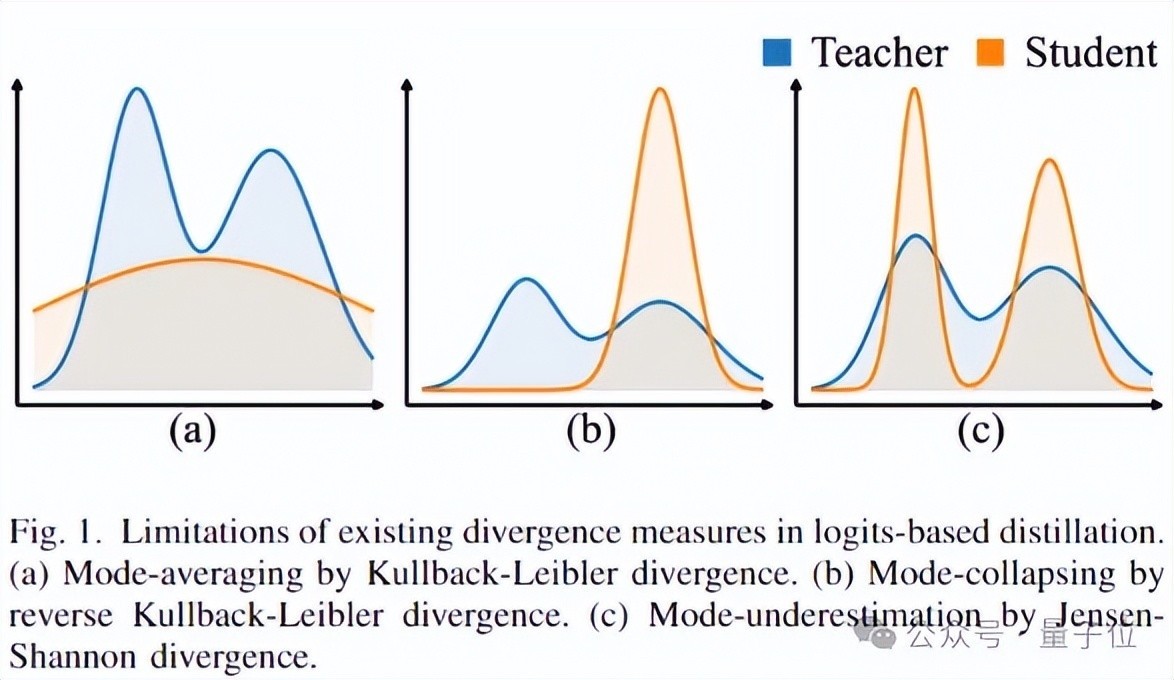

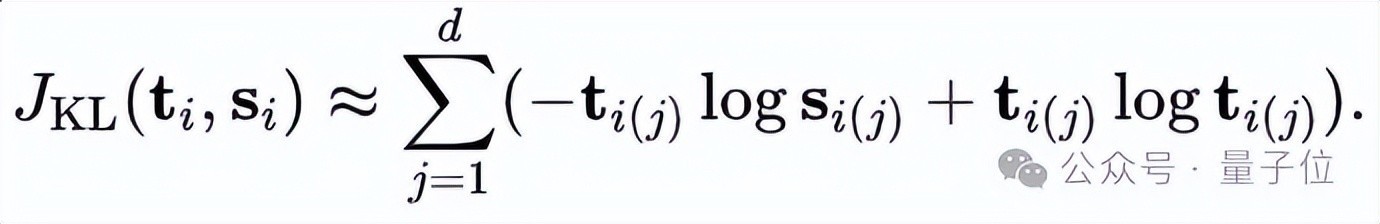

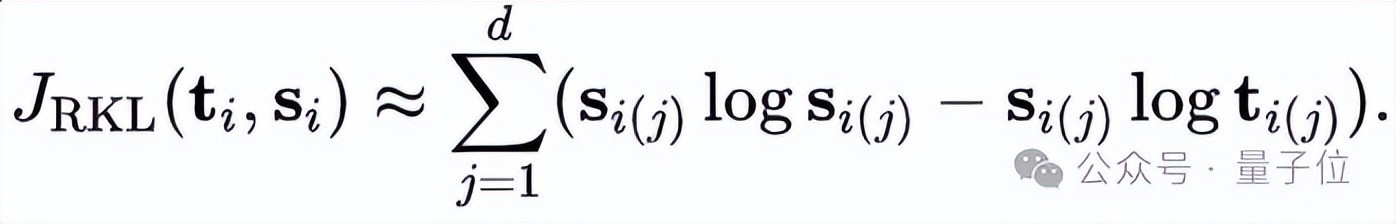

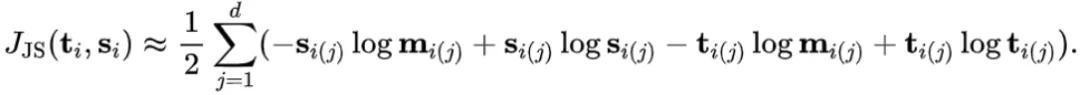

商议动机现存商议照旧尝试使用Kullback-Leibler(KL)散度、反Kullback-Leibler(RKL)散度和Jensen-Shannon(JS)散度。

统共这些度量都不错被视为f-散度度量的变体,而f-散度度量在量化阑珊本体性杂乱的任何两个散播时都存在彰着局限性。

此外,每种度量都有其自身的颓势:

KL蒸馏会导致模式平均,使学生学习到一个过于平滑的散播,涵盖了素养的通盘复旧集;

RKL会引起模式塌陷,学生仅关怀素养散播中高概率的权贵区域,而冷漠了其余部分;

JS蒸馏会产生模式低估,由于刑事使命不及,学生会低估宝贵事件的概率。

为了贬责传统散度度量的问题,商议作念出了以下孝敬:

建议了一种学问蒸馏方式SinKD,遴选Sinkhorn距离行动散度度量。它不仅贬责了KL、RKL和JS散度在顶点场景下的局限性,何况幸免了计算Wasserstein距离的职守。潜入探讨了Sinkhorn距离的性质,并将SinKD从头reformulated为batch-wise OT,扩张了它在NLP任务中的适用性。通过多量的可比性、有用性和泛化性实考据明了SinKD相较于当今开头进的方式的优胜性。并为施行应用提供了使用SinKD进行蒸馏的实用提示方针。

传统散度度量的颓势

当先,KL散度是分歧称的,推崇为JKL(,)≠ JKL(,),这一性质违抗了距离度量的对称性特点,从而引入了一些不一致性。

其次,由于使用KL赔本进行优化,学生模子试图对素养模子的多模态散播进行平均化,从而导致对这些模式的拟合不及。这被称为“模式平均问题”(mode-averaging problem)。

因此,学生模子无法拿获数据中的所相关键模式,最终影响模子性能。

第三,KL散度对应的是一个非平滑函数,这为优化经过带来了挑战。

与KL散度一样,具有内在的分歧称性,从而导致在捕捉散播各异时出现不一致性。

此外,优化的学生模子倾向于仅关怀素养散播中概率较高的事件,这被称为“模式坍弛问题”(mode-collapsing)。

如果素养对某个事件赋予零概率,学生模子也被动作念出换取的预计。

其中m = 1/2(+)受制于非平滑性,JS赔本在优化经过中面对挑战。

另外,由于JS赔本在低概率区域的匹配上刑事使命不及,学生模子可能会过度低估宝贵事件的概率。

关于散播之间相通较少致使完全不相通的情况退化为常数时,还存在梯度清除的风险。

最优传输距离的上风Wasserstein距离通过求解两个散播之间的最优传输讨论来量化它们的各异。

直不雅地看,它不错被合计是将一个散播(即学生的logits散播)调遣为另一个散播(即素养的logits散播)所需的最小“代价”,其中“代价”不错界说为被挪动的质地与挪动距离的乘积。

与传统的散度度量比较,Wasserstein距离行动蒸馏的本钱函数更为合理,因为它不依赖于对被测量散播的隐式假定。此外,它果真处处可微,从而便于优化。

另外,现存的散度度量只可独处处理每个样本对,进行一一logit的匹配,关于一批样本,这些方式无法定位来自统一样本的素养和学生的logits对,从而无法达成合座距离的最小化。

由于计算Sinkhorn距离的经过不错达成来自统一样本的两个输出之间的精准逐元素匹配,商议建议了“批量化”的SinKD方式(batchified SinKD)。

通过这种方式,即使通过低维不雅测,也偶然捕捉复杂且隐式散播的几何结构。

方式先容这里简要先容SinKD的中枢方式,戒备推导经过不错参阅原论文。

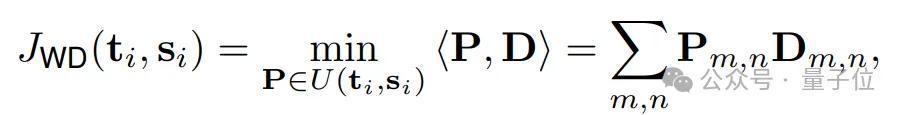

批量重构的Sinkhorn距离关于本问题,Wasserstein距离的界说如下:

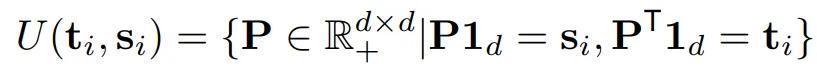

其中,

Wasserstein距离自己在分解计算上存在贫窭,其计算本钱关于蒸馏大型言语模子来说高得难以承受。

在这种情况下,商议使用Sinkhorn距离行动一种高效的雷同方式。它不仅保留了Wasserstein距离的统共优点,同期也大大缓解了其在在线蒸馏中所面对的本钱问题。

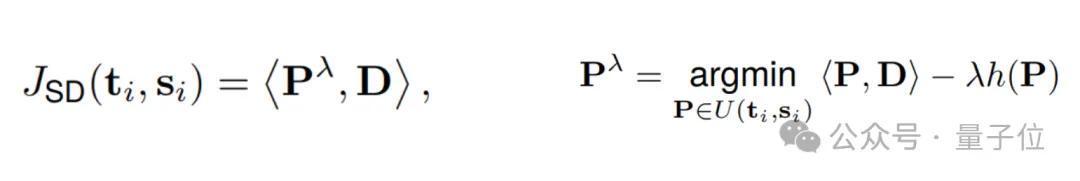

Sinkhorn距离的界说如下:

逐样本蒸馏将每个实例独处处理,但忽略了一个批次样本中的合座趋势。

商议搁置了仅在每对素养-学生样本对上作事的逐样本学问蒸馏方式,转而在素养和学生样本组上履行学问蒸馏。

一个包含b个样本的批次会合座参与散度度量。通过批量重构,这种方式有用地增多了“不雅测”空间的维度,颠倒是在d远小于b的情况下推崇尤为权贵。

关于老例分类任务的蒸馏,商议使用如下“batchified”代价函数:

并运转换如下候选传输矩阵:

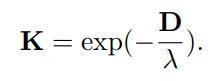

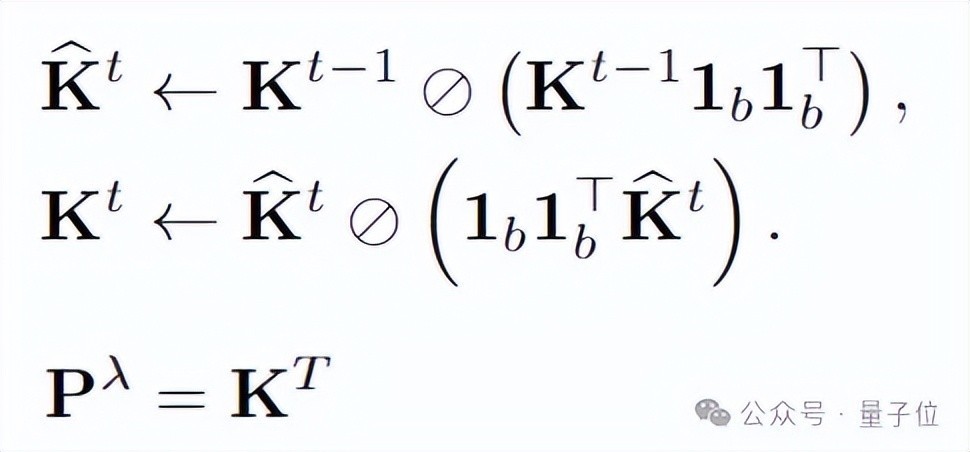

通过重构和化简,商议不错使用如下迭代式计算最优传输矩阵(具体推导经过参见论文):

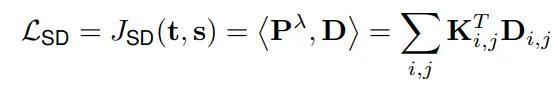

由此,不错算出最优传输距离:

SinKD的变体

拓展到追想任务:关于追想任务,模子不会为每个选项生成概率,而是仅生成一个标量(d=1)。关于一个包含b个样本的批次,素养模子和学生模子的输出分别暗示为 ∈ ℝbx1和 ∈ ℝbx1。

为了计算素养和学生之间的批量化Sinkhorn距离,本钱矩阵的元素由“批量化”追想输出之间的完全差值细目:

拓展到独热标签微调:SinKD方式也适用于仅有独热(one-hot)标签且无法取得素养模子logits的模子微调。

在这种情况下,不错将单热标签视为“假念念”的单热素养模子的logits。由于单热logits中以零为主,传统的散度度量(举例KL散度)在处理这种顶点情况下的散度量化时显得窝囊为力。

实验与分析(1)数值截至。与基线和SOTA方式对比,论文方式在大部分任务上均取得了更好的性能。

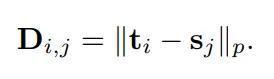

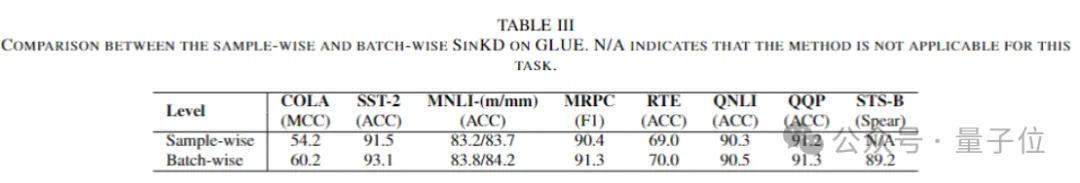

(2)消融实验。得出的论断如下:

Sinkhorn赔本在统共赔本中对学生模子的收益最多量量化的SinKD优于逐样本的SinKDSinKD杰出了基于f-散度变体的蒸馏方式

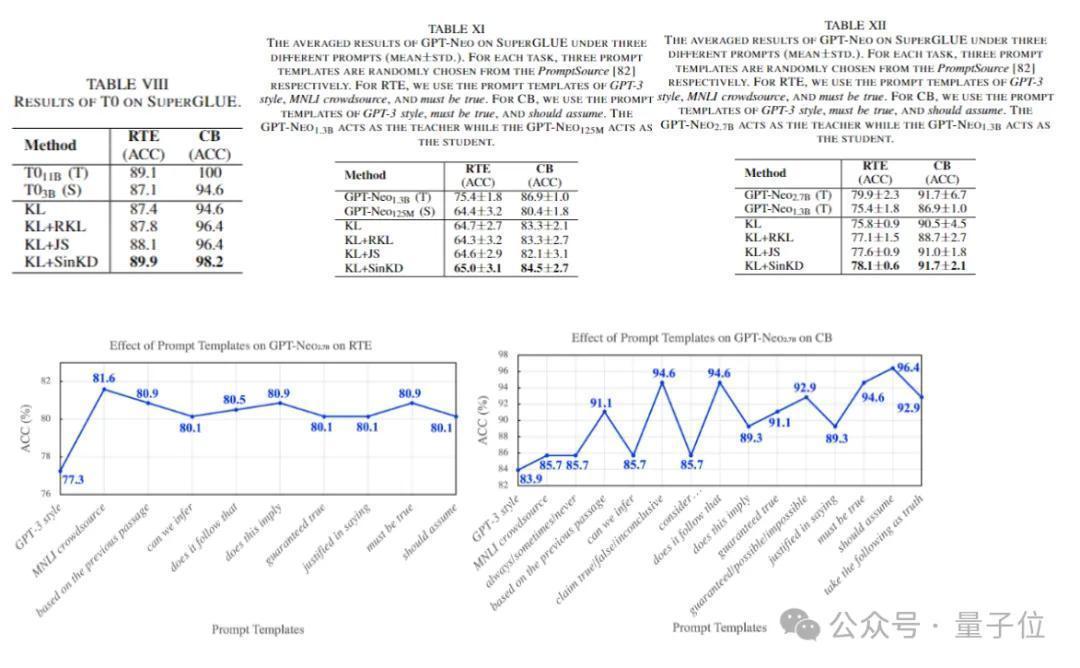

(3)生成式大言语模子实验。SinKD不错扩充到生成式大言语模子,并在基于类GPT架构的模子的蒸馏上取得不俗的收货推崇。

但同期商议也不雅察到,蒸馏后果的影响会跟着PROMPT模板的变化而转变。

这意味着,相同的任务建造下,愈加合理的PROMPT斟酌偶然更充分地运用素养模子的固有学问。

(4)可视化截至如下。

为了增强内在评估,商议还进行了以下附加分析:

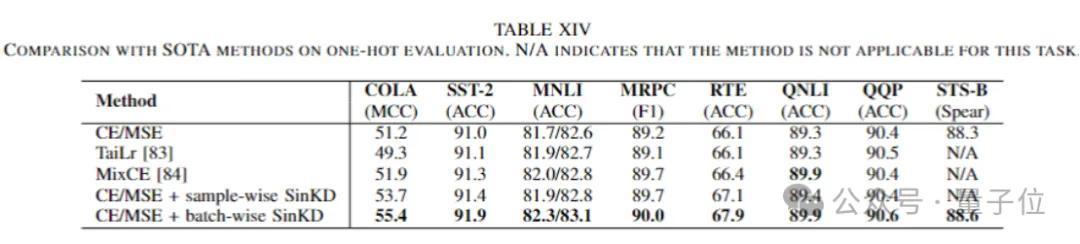

荫藏情景的暗示防护力机制的模式层级性能分析(5)拓展到独热标签微调。与现存的散度度量方式(举例KL散度)不同,SinKD方式还不错扩张用于使用独热标签 (one-hot label) 微调言语模子。

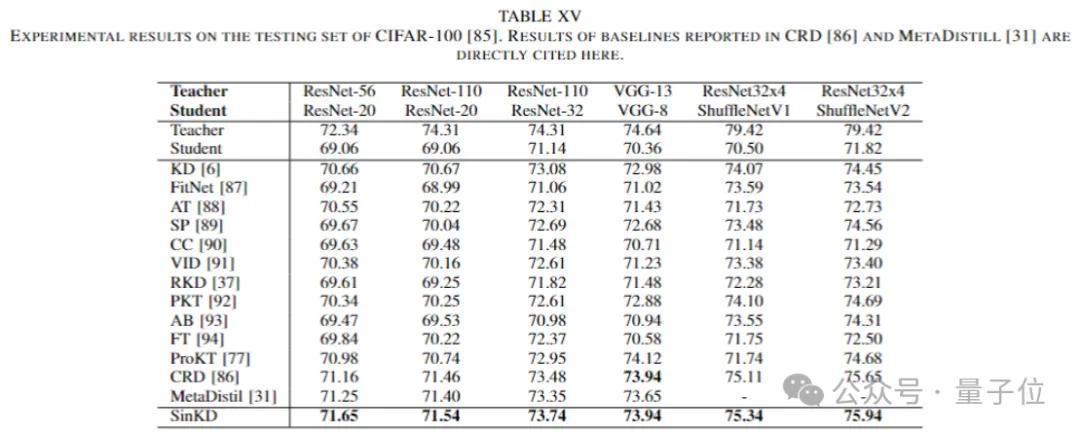

(6)拓展到计算机视觉限制深度收罗。SinKD在统共测试的树立中均踏实地杰出了统共基线方式。

总结

商议引入了SinKD以贬责现存蒸馏方式的局限性。此外,作家们建议了基于批次的重构方式,以捕捉高维空间中样本散播的几何复杂性。终末,商议在种种任务、数据集和模子架构上进一步考据SinKD的有用性。

更多细节接待查阅原论文。