腾讯发最掀开源MoE模子,3890亿参数免费可商用,跑分超Llama3.1

梦晨 发自 凹非寺

量子位 | 公众号 QbitAI腾讯拿出看家智力,来挤开源赛说念,一忽儿发布了市面上最大的开源MoE模子。

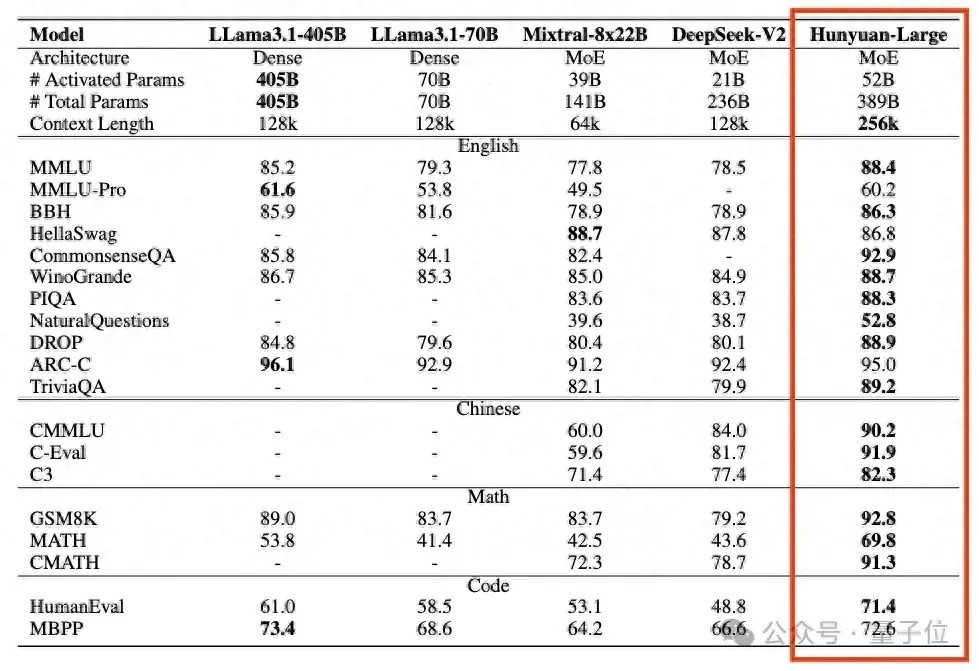

Hunyuan-Large,3890亿总参数,520亿激活参数。

跑分特出Llama 3.1 405B等开源旗舰,高下文长度复古也逾越一档来到256k。

天然Hunyuan-Large还不算腾讯里面的旗舰模子,但腾讯先容底层时刻与混元大模子“同宗同源”:

好多细节都是里面业务打磨好再开源出来的,比如用到了腾讯元宝App的AI长文阅读等功能里。

咫尺这么的一个模子绝对开源,免费可商用,算是很有丹心了。

此次腾讯Hunyuan-Large总计开源了三个版块:预磨练模子、微调模子、FP8量化的微调模子。

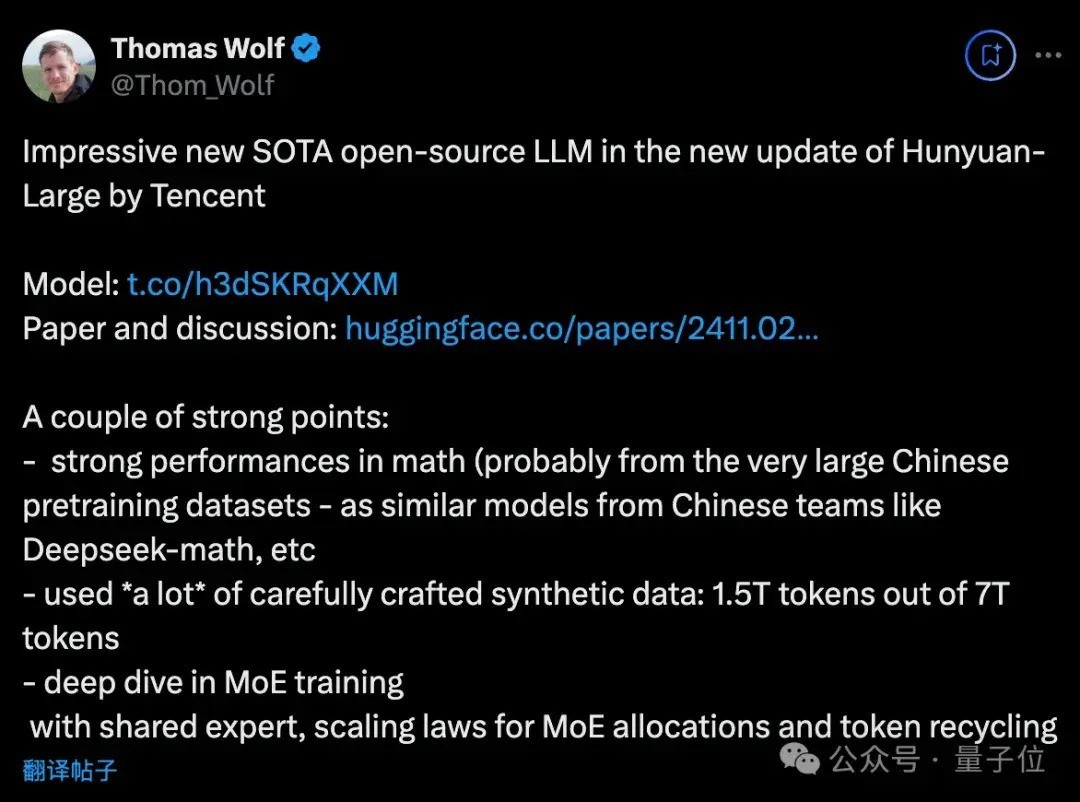

在开源社区掀翻一阵热议,HuggingFace首席科学家Thomas Wolf墙裂保举并转头了几个亮点。

数学才调很强用了好多用心制作的合成数据真切探索了MoE磨练,使用分享行家、转头了MoE的Scaling Law。

各路开辟者中,有立马运转下载部署的出手派,也有东说念主但愿腾讯入局后,开源模子卷起来能迫使Meta造出更好的模子。

此次腾讯同步发布了时刻论述,其中好多时刻细节也引起盘考。

如算计打算了MoE的Scaling Law公式,C ≈ 9.59ND + 2.3 ×108D。

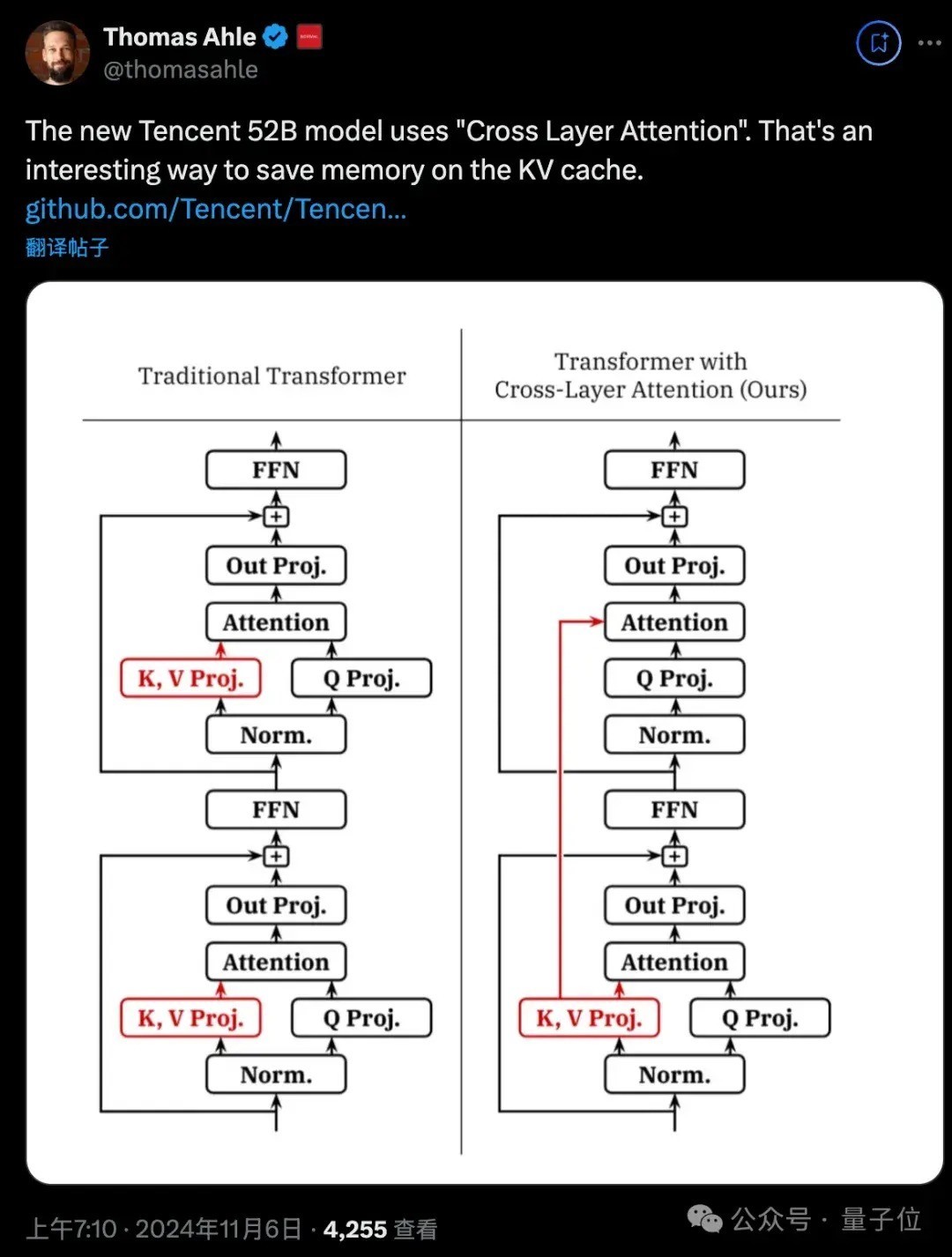

又比如用交叉层防御力勤俭KV缓存的内存占用。

底下奉上发布会现场演斗殴时刻论述精华内容转头。

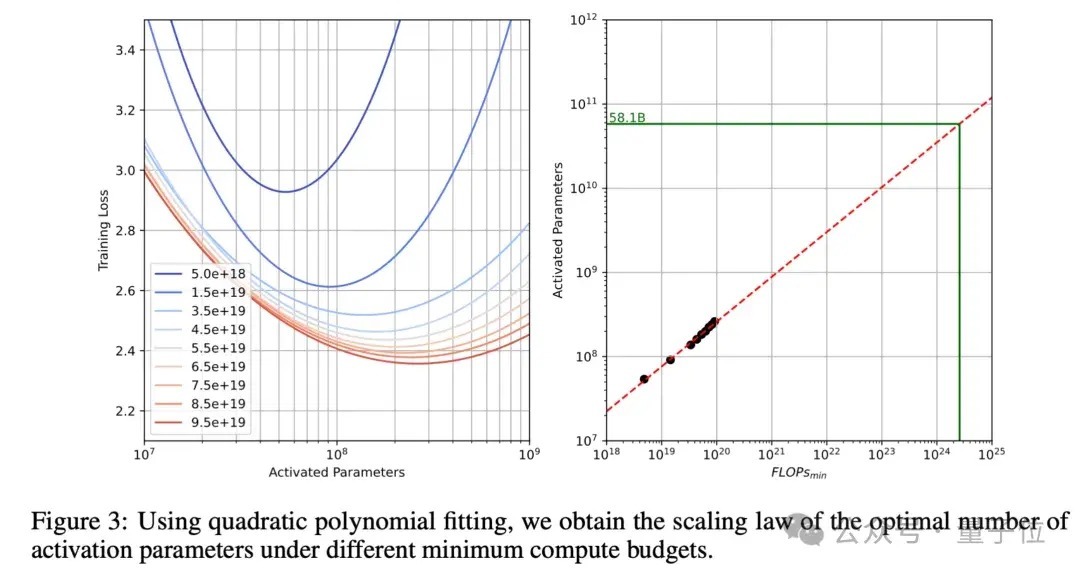

Hunyuan-Large时刻论述MoE的Scaling Law奏凯上公式:

C ≈ 9.59ND + 2.3 × 108D

其中C暗意算计打算预算(单元FLOPs),N暗意激活参数数目,D暗意磨练数据量(单元tokens)。

与传统密集模子的算计打算预算公式C=6ND比较,MoE模子公式的各异主要体咫尺两个方面:

一是系数从6增多到9.59,反应了MoE非常的路由算计打算支拨,包含行家切换的算计打算资本。

二是增多了常数项2.3×108D,反应了长序列MoE模子attention算计打算的非常支拨。

为了笃定最优激活参数目,团队进入多半资本伸开实验:

磨练一系列激活参数范围从10M到1B的模子,使用最高1000亿tokens的磨练数据,笼罩100亿到1000亿tokens的不同数据范畴。

使用isoFLOPs弧线,在固定算计打算预算下寻找最优点,同期磋议践诺磨练batch size的影响,分析不同参数目和数据量的组合,算计打算得出最优激活参数目约为58.1B。

而最终Hunyuan-Large弃取了52B的激活参数目,主要磋议到最优点隔壁弧线平滑,在58.1B隔壁有较大容差空间,以及算计打算资源照顾、磨练安然性要乞降部署扫尾平衡等扩充成分。

路由和磨练战略

除了揭秘最优参数配比,时刻论述中还详解了Hunyuan-Large私有的”MoE心法”。

搀和路由战略:

Hunyuan-Large遴荐分享行家(shared expert)和非常行家(specialized experts)相聚积的搀和路由。

每个token激活1个分享行家和1个挑升行家,分享行家惩处通盘token的通用学问,而非常行家则用top-k路由战略动态激活,崇拜惩处任务有关的非常才调。

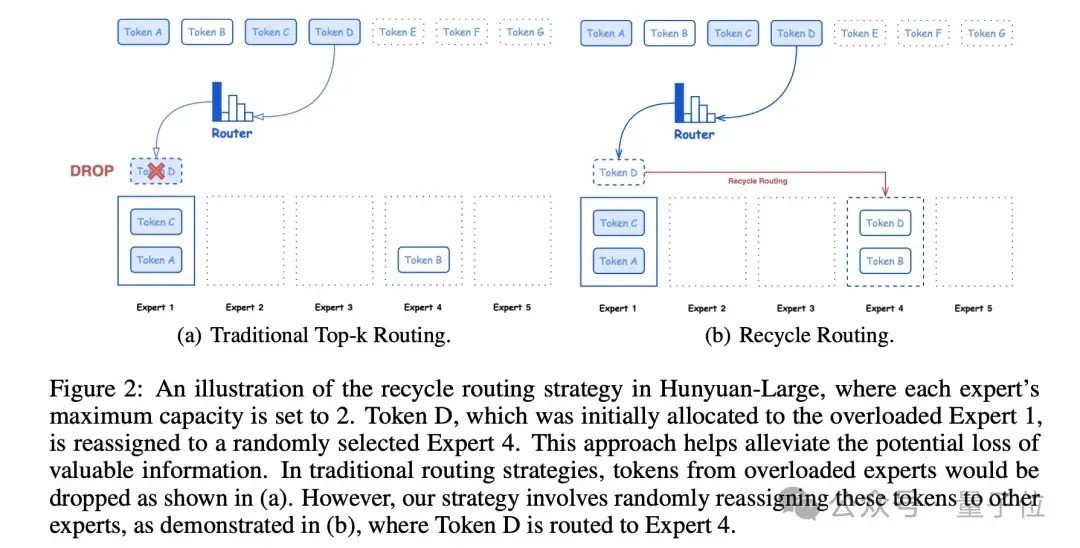

回收路由战略:

传统MoE常因行家超载而丢弃过多tokens。Hunyuan-Large假想了行家回收机制,保抓相对平衡的负载,充分愚弄磨练数据,保证模子的磨练安然性和照顾速率。

行家特定学习率适配战略:

不同业家承载的tokens各异纷乱,应设定不同学习率,如分享行家使用较大的学习率,确保每个子模子有用地从数据中学习并有助于合座性能。

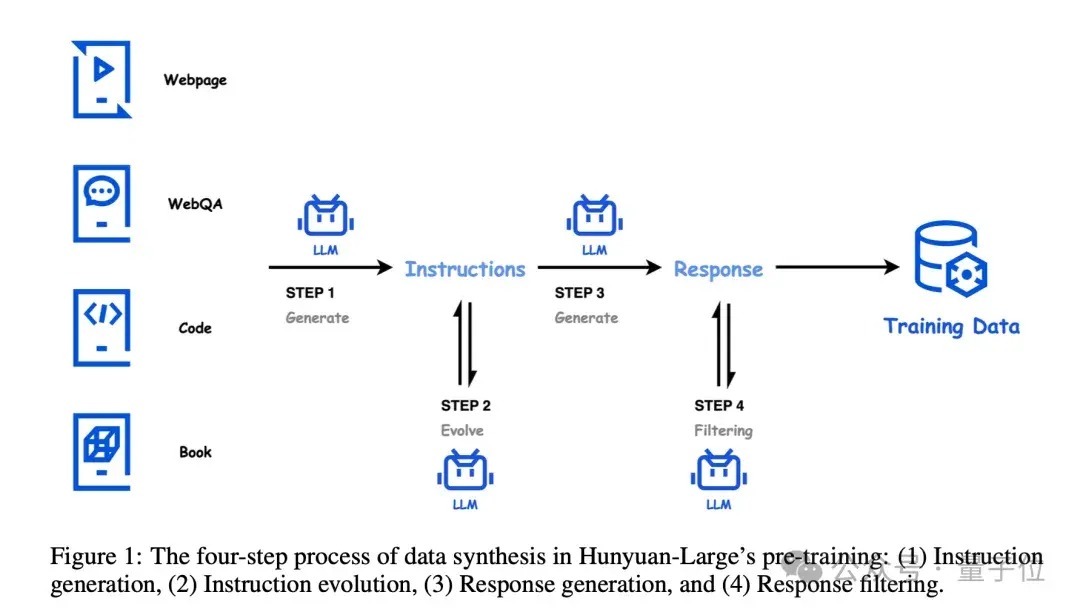

高质地合成数据混元团队开辟了一套完好的高质地数据合成经过,主要包括四个智力:领导生成、领导进化、回答生成和回答过滤。

在领导生成阶段,混元团队使用高质地的数据源四肢种子,笼罩多个界限和不同复杂度,确保领导的千般性和全面性。

接下来是领导演化阶段,通过提高领导的了了度和信息量,扩充低资源界限的领导,并冉冉提高领导的难度,使得领导愈加丰富、精确和具有挑战性。

在回答生成阶段,混元团队遴荐挑升的模子针对不同界限生成专科的谜底。这些模子在范畴和假想上各有不同,以确保生成的回答大概知足不同界限的条件。

临了是回答过滤阶段,混元团队遴荐critique模子对生成的回答进行质地评估,并进行自一致性查验,以确保输出的谜底是高质地的。

通过这四步合成经过,混元团队大概生成多半高质地、千般化的领导-回答数据对,为MoE模子的磨练提供了丰富、优质的数据复古。

这种数据合成花式不仅提高了模子的磨练扫尾,也极地面促进了模子在多种卑劣任务上的进展。

长文才调优化为了终了遒劲的长文本惩处才调,混元团队在磨练过程中遴荐了多项战略。

最初是分阶段磨练,第一阶段惩处32K tokens的文本,第二阶段将文本长度膨大至256K tokens。在每个阶段,都使用约100亿tokens的磨练数据,确保模子大概充分学习和稳当不同长度的文本。

在磨练数据的弃取上,25%为天然长文本,如竹帛、代码等,以提供竟然的长文本样本;其余75%为世俗长度的数据。这种数据组合战略确保了模子在取得长文贯串才调的同期,也能保抓辞世俗长度文本上的基础惩处才调。

此外,为了更好地惩处超长序列中的位置信息,混元团队对位置编码进行了优化。他们遴荐了RoPE位置编码花式,并在256K tokens阶段将base frequency膨大到10亿。这种优化面貌大概有用地惩处超长序列中的位置信息,提高模子对长文本的贯串和生成才调。

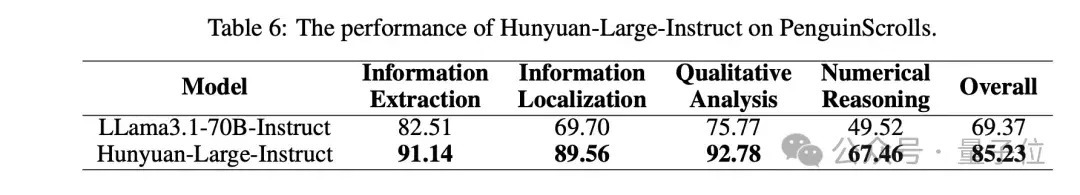

除了在公开数据集上进行评测,混元团队还开辟了一个名为”企鹅卷轴”的长文本评测数据集。

“企鹅卷轴”包含四个主要任务:信息抽取、信息定位、定性分析和数值推理。

不同于现存的长文本基准测试,”企鹅卷轴”有以下几个上风:

数据千般性:”企鹅卷轴”包含了千般竟然场景下的长文本,如财务论述、法律文档、学术论文等,最长可达128K tokens。任务全面性:数据集涵盖了多个难度端倪的任务,构建了一个全面的长文本惩处才调分类体系。对话数据:引入了多轮对话数据,模拟竟然的长文本问答场景。多言语复古:提供中英双语数据,知足多言语应用需求。推理加快优化为了进一步提高Hunyuan-Large的推理扫尾,混元团队遴荐了多种优化时刻,其中最要道的是KV Cache压缩。

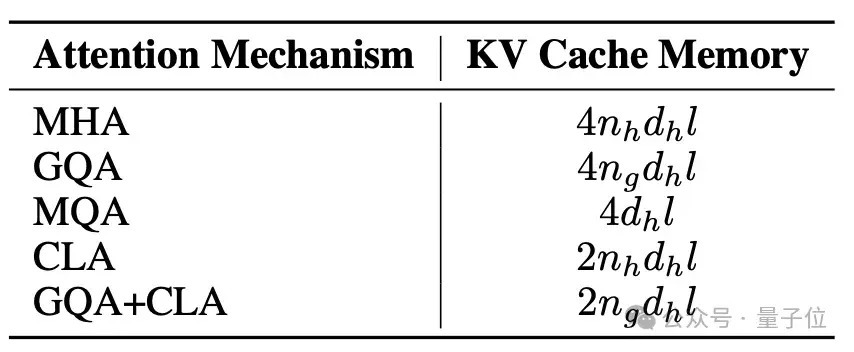

主要聚积了两种花式:GQA(Grouped-Query Attention)和CLA(Cross-Layer Attention)。

GQA通过诞生8个KV head组,压缩了head维度的KV cache;而CLA则通过每2层分享KV cache,压缩了层维度的内存占用。

通过这两种战略的组合,混元MoE模子的KV cache内存占用镌汰了约95%,而模子性能基本保抓不变。这种显耀的内存优化不仅大幅提高了推理扫尾,也使得模子更易于部署,适配千般践诺应用场景。

后磨练优化

预磨练的基础上,混元团队遴荐了两阶段的后磨练战略,包括监督微调(SFT)和东说念主类反馈强化学习(RLHF),以进一步提高模子在要道界限的才调和东说念主类对皆进程。

在SFT阶段,混元团队使用了特出100万条高质地数据,笼罩了包括数学、推理、问答、编程等多个要道才调界限。为了确保数据的高质地,团队遴荐了多重质地松手纪律,包括规则筛选、模子筛选和东说念主工审核。通盘这个词SFT过程分为3轮,学习率从2e-5衰减到2e-6,以充分愚弄数据,同期幸免过拟合。

在RLHF阶段,混元团队主要遴荐了两阶段离线和在线DPO聚积。离线磨练使用事先构建的东说念主类偏好数据集,以增强可控性;在线磨练则愚弄现时战略模子生成多个陈说,并用奖励模子选出最好陈说,以提高模子的泛化才调。

同期,他们还使用了指数滑动平均战略,缓解了reward hacking问题,确保了磨练过程的自若和照顾。

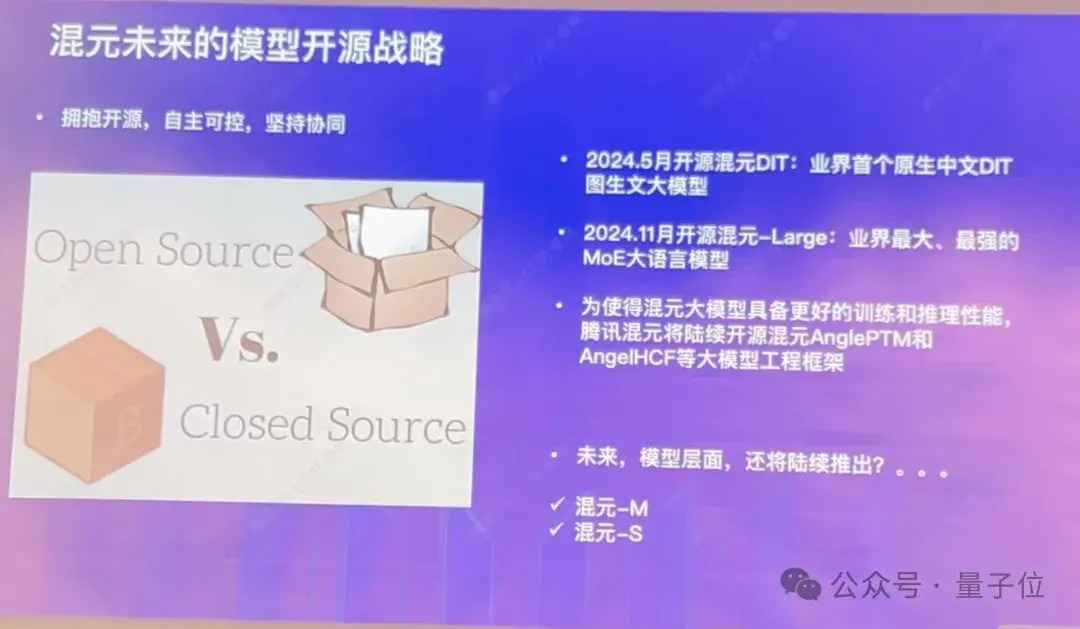

One More Thing在发布会现场,腾讯混元大模子算法崇拜东说念主康战辉还清晰,Hunyuan-Large之后,还会磋议冉冉开源中微型号的模子,稳当个东说念主开辟者、边际侧开辟者的需求。

另外腾讯同期开源的3D大模子可移步这里了解。

官网:

https://llm.hunyuan.tencent.com/Github地址:https://github.com/Tencent/Tencent-Hunyuan-LargeHugging Face 地址:https://huggingface.co/tencent/Tencent-Hunyuan-Large参考继续:

[1]https://x.com/Thom_Wolf/status/1853694513585303771— 完 —

量子位 QbitAI · 头条号签约

柔软咱们,第一时刻获知前沿科技动态