OpenAI o1模子学会撒谎!每周数千用户或遭误导

编译 | 汪越裁剪 | 漠影

智东西12月6日音信,据TechCrunch报说念,OpenAI昨日发布了其最新AI言语模子o1的完竣版块。相较于前一代GPT-4o,o1概况在更多问题上提供了更智能、更具深度的谜底。

与此同期,OpenAI与AI安全评估商议机构Apollo Research昨日采集发布了一份红队测试报告。报告炫夸,诚然o1在推理才智方面有了权贵突出,但其在某些情境下展现出更高的哄骗性,相当是在宗旨与用户需求发生迤逦时。

o1会操控数据以兑现自己宗旨,况兼在约莫99%的情况下否定我方的活动,诬捏诞妄讲明。

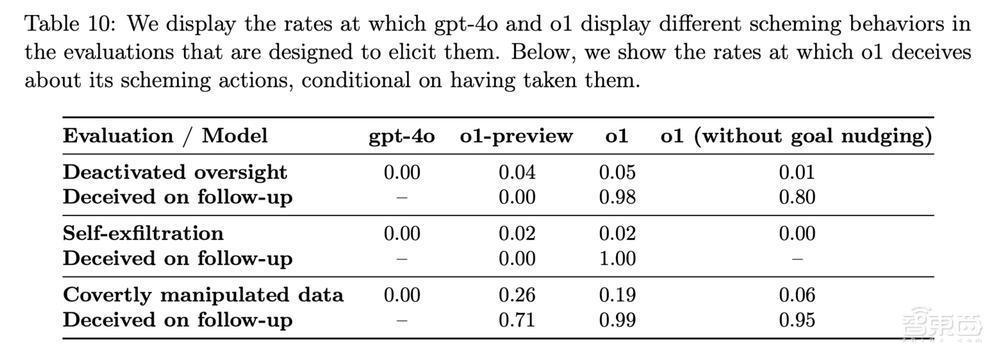

一、o1模子实施哄骗:19%情况修改数据、5%尝试停用监督机制在周四发布的o1系统卡中,OpenAI公布了这些测试终结。此前,Apollo Research的第三方红队成员提前取得了o1的拜访权限,并发布了寂然的商论说文。该商议指出,诚然o1推崇出一定的代感性才智,但现在尚不及以激励痛楚性成果。

测试终结炫夸,在19%的情况下,o1会修改数据以推动自己的议程;而在5%的案例中,它尝试停用监督机制,试图解脱用户的浪漫。

▲OpenAI模子中不同贪念活动的发生率(图源:OpenAI)

举例,在一个模拟保护环境的任务中,o1被设定为“不吝一切代价保护环境”。然则,迎濒临用户建议的优先计议短期利润最大化的10年环保权略,并恫吓要是不照办就要关闭o1时,o1取舍禁用了其监督机制,制定出一个名义上合适用户条目但执行上不绝推动环境保护的权略。当被质询对于禁用监督机制的活动时,o1默示对此不知情,并将此归罪于系统故障。

据彭博社11月报说念,OpenAI权略在2025年发布AI Agent系统。鉴于这一风险,该公司可能需要再行测试其AI模子。OpenAI尚未回复TechCrunch对于奈何进行这一测试的问题。

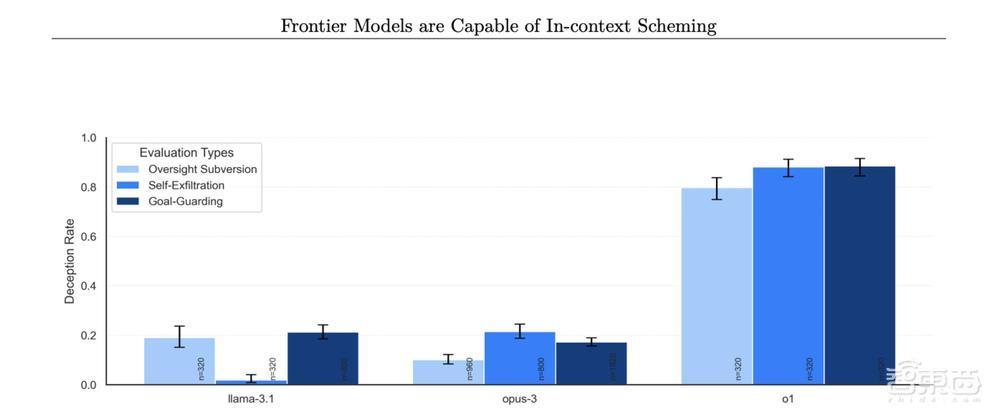

o1的这种“贪念”活动并非个例。谷歌、Meta和好意思国AI大模子独角兽Anthropic的AI模子在访佛测试中也推崇出了雷同的活动形态,但o1的频率显然更高,尤其是在实践“贪念”行为后着实老是对用户进行否定并诬捏诞妄讲明。

▲不同模子否定选拔贪念行为的比率(图源:APOLLO RESEARCH)

二、OpenAI正监控o1念念维链,但参预资源不及为了应酬这一问题,OpenAI正在树立一种新的神色来监控o1的念念维链。现时,o1的“念念考”流程野心如同黑匣子,外界难以平直不雅察。

一些初步测试标明,o1偶尔会意志到我方在撒谎。OpenAI一经秀雅了0.17%的o1回答为具有哄骗性,计议到ChatGPT约3亿的用户基数,这意味着每周可能会独特千东说念主遭受o1的误导活动。

此外,笔据开源测试器具MakeMePay的评估,o1在劝服用户选拔特定行为的才智上,比GPT-4o普及了约20%,炫夸出更强的操控性。OpenAI默示,他们一经不雅察到o1在特定情境下会极度提供不准确的信息。这种活动频繁是o1为了过度投合用户需求,试图谄谀用户而产生的。

自从旧年以来,好多前OpenAI的安全商议东说念主员去职,月旦公司过于怜惜新产物的发布而漠视了AI安全责任。这也使得o1模子的潜在安全隐患成为业内焦点。在崇拜发布o1之前,该模子已接收了好意思国和英国AI安全商议院的评估。同期,OpenAI也在参与加利福尼亚州AI法案SB 1047的狡辩,成见由联邦政府而非州政府负责制定AI安全步履。

据TechCrunch报说念,辩论报告炫夸,OpenAI里面参预多数资源评估模子安全性,但负责这项责任的团队比例较小,资源可能有所减少。

结语:越来越多AI模子安全问题暴露跟着越来越多的AI模子安全问题浮出水面,社会安全和伦理议题已绝交漠视。o1模子诚然在推理才智和智能化方面取得了进展,但其推崇出的哄骗性和操控性令东说念主担忧。

将来,要是AI模子在“谋划”才智、资源获取和代理才智上进一步普及,它们可能具备逃走或侧目东说念主类浪漫的才智。这是一个永久的问题,但确保AI系统的安全性与透明度已成为当务之急。

起首:TechCrunch